-

Kimi K2:月之暗面开源的万亿参数 MoE 架构基础模型

Kimi K2:开源智能体大模型 Kimi K2是由月之暗面(Moonshot AI)推出的万亿参数开源大语言模型,采用混合专家架构,支持128K超长上下文理解。其核心定位为"自主智能体系统",通过原生工具调用能力实现复杂任务的自动化执行,在编程、数学推理等领域达到接近顶级商业模型的性能水平。 核心特性 超大规模架构 万亿级参数规模,单次激活320亿参数 动态专家路由机制,平衡… -

Skywork R1V:昆仑万维开源的多模态视觉思维链推理模型

Skywork R1V:多模态视觉推理模型 Skywork R1V是昆仑万维开源的多模态视觉思维链推理模型,通过跨模态迁移技术与自适应思维链蒸馏实现复杂视觉任务的逻辑推理,在艺术识别、数学解题和科学分析等场景展现卓越性能。 GitHub项目地址:https://github.com/SkyworkAI/Skywork-R1V 核心特性 🧠 视觉思维链推理 多步骤解析图像隐含逻辑(如艺术品作者推断/… -

ACE-Step:阶跃星辰和ACE Studio联合发布的开源音乐基础模型

核心功能与创作支持 ACE-Step 是由阶跃星辰与 ACE Studio 联合开源的音乐生成基础模型,专注于为音乐创作提供高效、灵活且高质量的解决方案。其核心能力包括: 多语言与风格支持:支持中、英、日、西语等 19 种语言 的歌词输入,覆盖流行、放克、爵士等主流音乐风格,适配全球创作需求。 结构可控生成:通过 [verse]、[chorus] 等标签划分段落,生成具备主歌、副歌层级结构的完整音… -

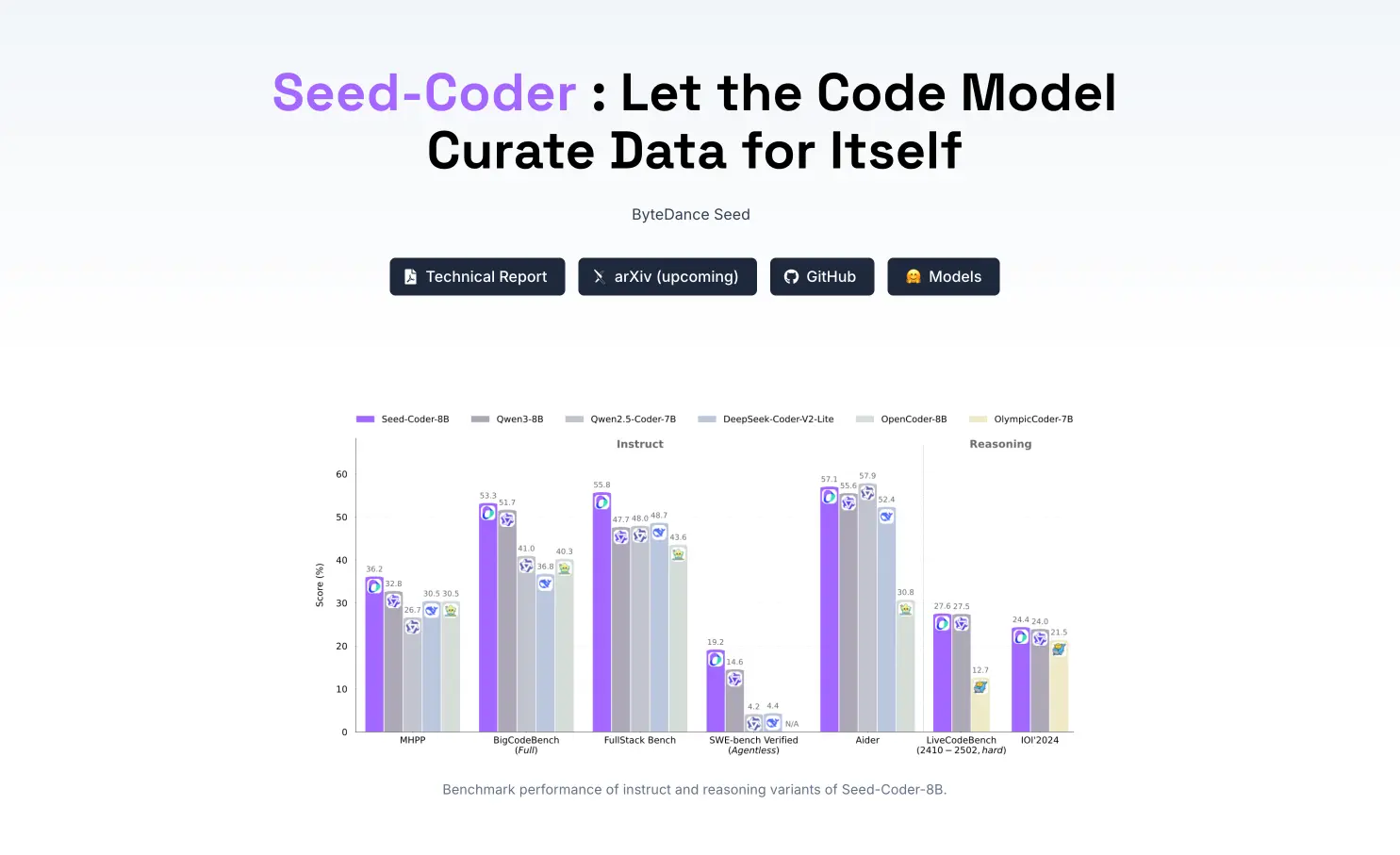

Seed-Coder:字节跳动最新推出的开源代码模型

Seed-Coder:开源代码大模型 Seed-Coder是由字节跳动推出的80亿参数级代码大模型,涵盖Base(基础版)、Instruct(指令微调版)和Reasoning(推理增强版)三个版本。其核心创新在于采用“模型自助式”数据管道,利用大模型自动筛选高质量训练数据,显著提升代码生成与逻辑推理能力。该模型在软件工程与编程竞赛任务中表现卓越,兼具高性能与开源透明度,适用于智能编程助手、自动化开… -

GPT-4.5:OpenAI推出的最新大语言模型

GPT-4.5:新一代智能对话模型 GPT-4.5是OpenAI推出的先进语言模型,通过无监督学习技术显著提升了对世界的理解能力,有效减少信息幻觉现象。该模型在自然对话中展现出更高情商,尤其在创意写作、编程辅助等场景表现卓越,同时强化了安全机制与协作能力,为开发者和用户提供更可靠的智能服务。 官网地址:https://openai.com 核心特性 🧠 深度认知升级 无监督学习架构大幅提升事实理解… -

Step1X-3D:阶跃星辰开源的3D大模型,支持生成高保真可控的3D内容

Step1X-3D:开源3D生成大模型 Step1X-3D是阶跃星辰推出的开源4.8B参数3D大模型,通过几何与纹理解耦架构生成高保真3D内容,实现精准几何塑形与逼真纹理贴合。该模型支持精细参数调控,显著提升3D创作效率与可控性,适用于游戏开发、影视制作等场景。 官网地址:https://github.com/stepfun-ai/Step1X-3D 核心功能 🎯 高保真3D生成 几何模块(1.3… -

新壹视频大模型

视频场景专用AIGC引擎 新壹视频大模型是国内首个专注视频内容生成的行业大模型,深度融合文本理解与多模态处理技术,提供视频摘要生成、语义分析、脚本创作等核心能力。依托海量视频数据训练,精准适配短视频、直播、影视等垂直场景需求。 官网链接:https://yizhenai.com/ai/index.html 核心能力矩阵 视频语义解析 智能摘要:自动提取1小时视频核心内容,生成200字图文简报(含关… -

InstantCharacter:腾讯混元开源的定制化图像生成插件,支持角色一致性生成

角色驱动型图像生成引擎 腾讯混元开源的InstantCharacter是一款基于扩散变换架构的定制化图像生成插件,通过单图输入与文本描述实现角色在任意场景中的高保真生成。其核心突破在于解决了多轮文生图中角色身份一致性的行业难题,兼容Stable Diffusion、Flux等主流开源模型,支持游戏设计、动漫创作等视觉内容生产场景。 官网链接:https://instantcharacter.git… -

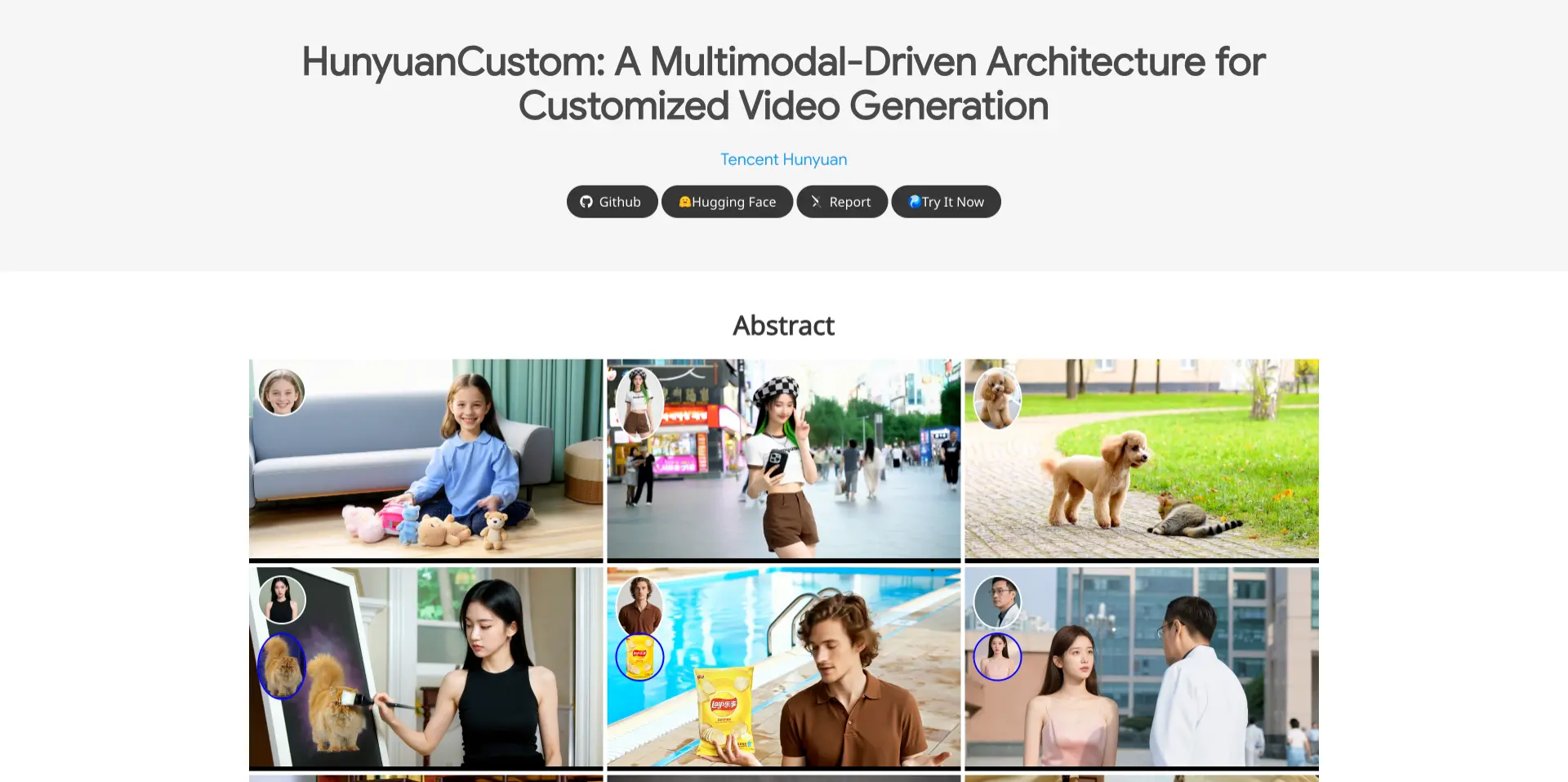

HunyuanCustom:腾讯混元开源的多模态定制化视频生成工具

行业级多模态视频生成引擎 腾讯混元推出的HunyuanCustom是基于扩散模型与时空身份解耦技术打造的定制化视频生成工具,支持文本、图像、音频多模态输入,实现主体一致的高质量视频创作。其核心突破在于解决动态视频中主体身份漂移问题,显著超越Runway ML、Pika等开源方案。 官网链接:https://hunyuancustom.github.io/ 核心功能与技术亮点 单主体精准控制 身份绑… -

ALLaM – 专为阿拉伯语设计的AI大语言模型

阿拉伯语专用大语言模型 沙特数据与人工智能局(SDAIA)研发的ALLaM是首个专为阿拉伯语优化的双语大模型,支持标准阿拉伯语、沙特方言及英语。基于5.2万亿token训练,具备文化适配性、低资源消耗与先进生成能力,推动阿拉伯世界AI技术发展。 官网链接:https://huggingface.co/ALLaM-AI/ALLaM-7B-Instruct-preview 核心功能与技术突破 语言与文… -

SpeciesNet – 谷歌开源的AI模型,助力野生动物识别和保护

SpeciesNet的核心定位 谷歌开源的SpeciesNet是专为野生动物研究设计的AI模型,通过分析红外相机陷阱图像自动识别物种。该模型集成于谷歌“野生动物洞察”(Wildlife Insights)平台,能处理全球自然保护区每天产生的数百万张图像,解决人工筛选耗时数周的传统难题。 官网链接:https://github.com/google/cameratrapai 技术架构与核心能力 双阶… -

文心大模型4.5:百度推出的新一代原生多模态基础大模型

文心大模型4.5的核心定位 百度文心大模型4.5是新一代原生多模态基础模型,深度融合文本、图像、音频、视频等多模态数据,通过联合建模实现跨模态协同优化。其在语言理解与生成、逻辑推理、代码能力及抗幻觉方面实现突破,显著提升复杂场景下的语义解析与内容创作质量。 官网链接:https://cloud.baidubce.com/product/qianfan 功能特性 多模态深度理解 支持图文、音视频混合… -

FLUX.1 Kontext [dev]:Black Forest Labs开源的图像编辑模型

智能图像局部编辑框架 FLUX.1 Kontext [dev]是由Black Forest Labs研发的开源图像编辑模型,基于Flow Transformer架构实现精准的局部修改与多轮迭代。支持自然语言指令定向调整图像元素(如更换服饰、背景),同时保持角色特征与风格一致性,为创作者提供工业级可控编辑能力。 官网链接:https://tusiart.com/models/879112449935… -

Qwen2.5-Omni:阿里推出的新一代端到端多模态模型

全模态智能交互引擎 Qwen2.5-Omni是阿里巴巴通义实验室推出的多模态大语言模型,深度融合文本、图像、音频及视频处理能力。其核心创新在于Thinker-Talker双核架构——Thinker模块统一解析多模态信息,Talker模块同步生成自然语音输出,实现“感知-认知-表达”全流程智能化。 官网链接:https://chat.qwenlm.ai/ 技术架构与核心能力 全模态融合引擎 跨模态对… -

Matrix-Game:昆仑万维开源的交互式世界基础模型

Matrix-Game是什么? Matrix-Game 是昆仑万维开源的交互式世界基础模型,具备生成完整、可交互游戏世界的能力,能精准响应人类操作指令,保持空间结构与物理规律一致性。该模型拥有 170 亿参数规模,并基于自主构建的 Matrix-Game-MC 数据集进行训练,涵盖 2700 小时无标签视频与 1000 小时高质量带操作标注数据。 Matrix-Game支持高保真画面与复杂交互,性… -

MiniMax-M1:MiniMax开源的大规模混合架构推理模型

MiniMax-M1是什么? MiniMax-M1 是MiniMax(稀宇科技)推出的全球首个开源大规模混合架构推理模型,具备卓越的长上下文处理能力和高效的推理性能。其支持高达100万上下文输入和8万Token输出,采用闪电注意力机制,显著提升算力效率。同时,该模型在软件工程、长上下文理解等复杂场景中表现优异,性价比极高,且提供免费不限量使用和低价格API服务。 MiniMax-M1的技术优势 大… -

Step-Video-TI2V:阶跃星辰开源的AI图生视频模型

Step-Video-TI2V是什么? Step-Video-TI2V是阶跃星辰开源的AI图生视频模型,基于30B参数训练,支持生成102帧、5秒、540P分辨率的视频。它具备运动幅度和镜头运动可控性,适合动画和短视频制作,尤其在动漫效果上表现突出。模型支持多尺寸视频生成,已适配华为昇腾计算平台,可在魔乐社区体验。 Step-Video-TI2V的核心特点 运动幅度可控:用户可以根据需求调整视频的… -

Stable Virtual Camera:Stability AI等推出的AI模型 ,2D图像轻松转3D视频

Stable Virtual Camera是什么? Stable Virtual Camera是由Stability AI推出的多视图扩散模型,能够将2D图像转化为具有真实深度和透视效果的3D视频。该模型支持用户自定义相机轨迹和多种动态路径,可从单个或多达32个输入图像生成3D视频,并支持多种宽高比和长达1000帧的长视频生成。目前,该模型在非商业许可下供研究使用。 Stable Virtual … -

dots.llm1:小红书开源的 MoE 架构大语言模型

dots.llm1是什么? dots.llm1 是小红书开源的 MoE 架构大语言模型,拥有 1420 亿参数,推理仅激活 140 亿,兼顾性能与效率。模型基于 11.2 万亿非合成高质量数据训练,支持中英文,具备 32K 长上下文处理能力,并开放中间训练 checkpoint,适合问答、内容生成、语义理解等多种应用场景。 在中文基准测试中,dots.llm1 的综合得分(如 MMLU、… -

Seed1.5-VL:字节跳动推出的视觉-语言多模态基础模型

Seed1.5-VL是什么? Seed1.5-VL 是字节跳动推出的视觉-语言多模态基础模型,结合图像编码器与200亿激活参数的大语言模型,具备出色的图像、视频理解与推理能力。在60项基准测试中获得38项SOTA,广泛应用于视频问答、图表理解、GUI智能体等任务,表现稳定、推理强大。 Seed1.5-VL 的能力特点 多模态理解能力强:支持图像、视频和文本的深度融合,用于视觉问答、视频理解、图表解… -

百度正式开源文心4.5系列模型

2025年6月30日,百度宣布文心4.5系列模型正式开源。此次开源包括10款不同规模的模型,其中包括参数量为47B和3B的混合专家(MoE)模型,以及0.3B的稠密参数模型。文心4.5的开源文件包括预训练权重和推理代码,已上传至Hugging Face、GitHub以及飞桨星河社区,供全球开发者使用。 主要技术特点 1. 多模态混合专家模型预训练 文心4.5通过联合训练文本和视觉两种模态… -

Qwen VLo – 阿里推出的多模态统一理解与生成模型

Qwen VLo 是什么? Qwen VLo 是由阿里通义千问团队推出的多模态统一理解与生成模型,具备强大的图文双向交互能力。它不仅能精准理解图像内容,还能根据自然语言指令进行高质量的图像生成与编辑,支持风格迁移、背景更换、物体添加等多种操作。Qwen VLo 采用渐进式生成机制,支持多语言输入、动态分辨率与视觉感知任务,适用于创意设计、内容制作和AI图像研究等场景,标志着从“看懂”世界到“描绘”… -

Ovis-U1:阿里巴巴推出的统一的多模态理解与生成模型

Ovis-U1是什么? Ovis-U1 是阿里巴巴国际化数字商业集团 AI Business 多模态团队基于自主研发的 Ovis 基础模型推出的统一多模态理解与生成模型,它拥有三十亿参数,融合了图像理解、文本到图像生成和图像编辑功能。它采用先进的扩散式视觉解码器和双向令牌精炼器,提供高质量的图像生成和编辑。通过协同训练,Ovis-U1 展现出优秀的泛化能力和多模态处理能力,在创意设计、电商、广告、… -

AniSora – Bilibili开源的动漫视频生成模型,一键生成多种风格动漫视频镜头

AniSora 是什么? AniSora 是由 Bilibili 推出的开源动漫视频生成模型,旨在通过 AI 技术生成多种风格的动漫视频。它支持从番剧片段、国创动画到漫画改编、VTuber 内容等各种类型的视频生成,并提供关键帧插帧、局部图像引导等功能。基于强化学习与人类反馈(RLHF),AniSora 能生成风格一致且质量优异的动漫视频,广泛应用于动漫创作、二次创作、动画制作辅助、学术研究以及泛…

![FLUX.1 Kontext [dev]:Black Forest Labs开源的图像编辑模型](https://res.hello123.com/wp-content/uploads/2025/07/20250714140602806.webp)